Attention Is All You Need

תבנית ספר ריקה Attention Is All You Need (באנגלית; בתרגום חופשי לעברית: "תשומת לב היא כל‑מה שנדרש") הוא מאמר מחקרי משנת 2017, המזוהה כאחד מעמודי התווך של הבינה המלאכותית המודרנית.[1] במאמר הוצגה לראשונה ארכיטקטורת הטרנספורמר (Transformer), המחליפה רשתות חוזריות (RNN, LSTM) וקונבולוציוניות במנגנון קשב עצמי (self‑attention) רב‑ראשי, ובכך מאפשרת עיבוד מקבילי של רצפים ארוכים ומאיצה משמעותית את זמן האימון.[2][3]

החוקרים – שמונה מהנדסים וחוקרים מ‑Google Brain (אנ') ואוניברסיטת טורונטו – הדגימו במאמר שיפור ניכר במשימת תרגום מכונה מאנגלית לגרמנית לעומת רשתות עצביות חוזרות (אנ') בנות התקופה. תוצאותיהם הניחו את היסודות למודלים מתקדמים כדוגמת BERT, GPT ו-ViT (אנ'), ובכך שינו את קצב הפיתוח של מודלי עיבוד שפה טבעית וראייה ממוחשבת.[4]

החל מפרסומו אומצה ארכיטקטורת ה‑Transformer ברוב יישומי הבינה המלאכותית היוצרת: ממנועי תרגום, דרך מודלים לשאלות ותשובות, ועד מערכות יצירת תמונה וטקסט כגון Stable Diffusion ו‑ChatGPT. במקביל, חברות וארגונים תעשייתיים ניצלו את הפשטות והסקלביליות של המודל לפיתוח שירותים מסחריים מבוססי LLM.

נכון ליוני 2025 המאמר צוטט ביותר מ‑173,000 עבודות אקדמיות, עובדה המציבה אותו בעשירייה הפותחת של המאמרים המצוטטים ביותר במאה ה‑21.[5][6] השפעתו ניכרת לא רק בהתקדמות מדעית אלא גם בדיונים על עלויות אנרגיה, הטיות אלגוריתמיות ואתגרי רגולציה של מודלים ענקיים. בעוד שמבקרים מצביעים על צריכת משאבים גבוהה ועל סיכונים אתיים, הספרות המקצועית רואה בו נקודת מפנה בתולדות הלמידה העמוקה.[7]

רקע והכרה בצורך

בעשור שקדם למאמר, עיבוד שפה טבעית הסתמך בעיקר על רשתות עצביות חוזריות (RNN) וגרסאות משודרגות שלהן כגון LSTM ו-GRU. ארכיטקטורות אלו סבלו משלושה חסרונות בולטים:

- חישוב סדרתי שאינו מנצל במלואו את המקביליות של מעבדי GPU.

- קושי בלכידת תלויות ארוכות-טווח עקב התופעה המוכרת של דעיכת (או התפוצצות) גרדיאנטים.[8]

- זמן אימון ארוך ומורכבות היפר-פרמטרית.

הוספת מנגנוני קשב (attention) לרשתות חוזריות שהוצגה לראשונה ב-2014 שיפרה את הדיוק, אך הלולאה החוזרית נותרה צוואר-בקבוק.[9] פתרונות מבוססי רשתות קונבולוציה לרצפים, כגון *Convolutional Sequence to Sequence*, הציעו מקביליות חלקית אך דרשו עומק רב כדי להרחיב את שדה הקליטה, מה שהכביד על האימון.[10]

לקראת 2017 נדרש מודל המנצל מאיצי GPU/TPU רוחביים ללא תלות סדרתית. צוות Google Brain הציע לבסס את המודל כולו על מנגנון קשב-עצמי, ללא שכבות חוזרות או קונבולוציות, ובכך נולד הטרנספורמר. הארכיטקטורה פותחה במקור עבור תרגום מכונה, אך החופש ממגבלות סדרתיות העניק לה סקלביליות שסללה את הדרך למודלי שפה ענקיים, ראייה ממוחשבת וחיזוי מבנה חלבונים והפכה לנקודת מפנה בלמידה העמוקה.

מסמך קודם בנושא נקרא "טרנספורמרים: תשומת לב עצמית איטרטיבית ועיבוד עבור משימות שונות", וכלל איור של שש דמויות של רובוטריקים (Transformers באנגלית).

כותרת המאמר היא התייחסות לשיר "All You Need Is Love" של הביטלס. השם "טרנספורמר" נבחר משום שג׳אקוב אוסקורייט, אחד ממחברי המאמר, אהב את צליל המילה.

כמה דוגמאות מוקדמות עליהן ניסה הצוות את ארכיטקטורת הטרנספורמר שלהם כללו תרגום מאנגלית לגרמנית, יצירת מאמרי ויקיפדיה בנושא "The Transformer" וניתוח מחרוזות. אלה שכנעו את הצוות שהטרנספורמר הוא מודל שפה למטרות כלליות, ולא רק טוב לתרגום

פיתוח וכתיבת המאמר

צוות המחקר

המאמר נכתב על‑ידי שמונה חוקרים מ‑Google Brain, Google Research ואוניברסיטת טורונטו: אשיש ואסואני, נועם שזיר, ניקי פרמר, ג'אקוב אוסקורייט, ליון ג'ונס, איידן גומז, לוקאש קייזר ואיליה פולוסוחין. ארבעת הראשונים הובילו את ניסוח הארכיטקטורה, בעוד ג'ונס וגומז התמקדו ביישום קוד המקור ב-TensorFlow, וקייזר ופולוסוחין בנו את האימון וההערכה.[11]

תהליך הכתיבה והפרסום

בראיונות מאוחרים, אמרו החוקרים כי הדחף העיקרי לכתיבת המאמר היה קיצור דרמטי של זמן האימון במערכות תרגום מכונה, שדרש שבועות בהגדרות RNN טיפוסיות. הטיוטה הראשונית, שכותרתה "Transformers: Self‑Attention Iterative Processing for Diverse Tasks", כללה איור של שישה רובוטריקים והוגשה ביוני 2017. המאמר התקבל ל‑NIPS 2017 (לימים NeurIPS)(אנ') בשיעור קבלה של כ‑21%, והוצג בכרזה בפברואר 2018.[12]

בעת הכתיבה נעשה שימוש במערך נתונים WMT 2014 En‑De ו‑En‑Fr, תוך ניצול 8 מעבדי GPU מסוג Nvidia P100. זמן האימון הכולל הופחת מכ‑10 ימים (ב‑GNMT) לכ‑12 שעות בלבד. תרשים האימון וההערכה פורסם בקוד פתוח במסגרת פרויקט Tensor2Tensor, שחולק ברישיון Apache 2.0 ואִפשר לקהילה לאמת ולשחזר את התוצאות מהר.[13]

לצד סקירת עמיתים בכנס, שוחרר המאמר לארכיון פתוח והצית גל שחזורים בתעשייה ובאקדמיה; בתוך שנה הופיעו יותר מ‑250 עבודות המשוות או משפרות את הטרנספורמר.

לאחר פרסום המאמר, כל אחד מהכותבים עזב את גוגל כדי להצטרף לחברות אחרות או להקים סטארט-אפים. כמה מהם הביעו תחושות של חוסר יכולת לחדש ולהרחיב את הטרנספורמר בכיוון הרצוי, אילו היו נשארים בגוגל.[14]

ארכיטקטורת הטרנספורמר

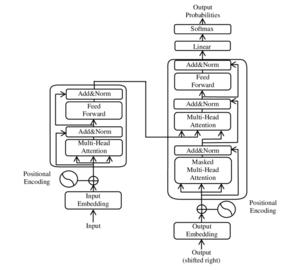

הטרנספורמר בנוי משני רכיבים סימטריים: מקודד (encoder) ומפענח (decoder). כל אחד מהם מורכב מערימה (stack) של בלוקים זהים; הגרסה המקורית במאמר השתמשה בשישה בלוקים בכל צד. בכל בלוק משולבים מנגנון קשב‑עצמי רב‑ראשי, שכבת האכלה קדימה, חיבורים שאריים (residual) ועיבוד נורמליזציה.

קשב‑עצמי רב‑ראשי (Multi‑Head Self‑Attention) - מנגנון הקשב העצמי מחשב משקלים בין כל זוג מיקומים ברצף הקלט, ומאפשר למודל "להתמקד" בטוקנים רלוונטיים ללא תלות במרחקם. חישוב הקשב מבוצע במקביל בשמונה "ראשים" (heads), שכל אחד מהם לומד התפלגות משקלים נפרדת; הפלטים מאוחדים (concatenate) וממופים ל‑dmodel. פירוק רכיבי ה‑query, key ו‑value לתתי‑מרחבים קטנים מפחית עלות חישובית ומאפשר המרת מידע מגוונת.[15]

קידוד מיקום (Positional Encoding) - מאחר שהטרנספורמר חסר מבנה סדרתי מפורש, הוא מקבל וקטורי סינוס וקוסינוס בתדרים שונים, הנוספים לקלט בשכבת האמבדינג. קידוד זה מאפשר למודל להבחין בסדר הטוקנים וללמוד יחסים יחסיים בין מיקומים.

שכבת האכלה קדימה (Feed‑Forward Network) - בין פעימות קשב רצופות ממוקמת רשת הזנה קדימה, הפועלת על כל מיקום בנפרד ואורכה שני שלבי דחיסה‑הרחבה (dmodel → dff → dmodel). בשימוש בערכי ברירת‑המחדל dff=2048, פעולה זו מוסיפה אי‑ליניאריות ומגדילה את קיבולת הייצוג.

חיבורים שאריים ונורמליזציה - הטרנספורמר משתמש בחיבור שארי (Residual) סביב כל תת‑מנגנון, ולאחריו נורמליזציית שכבה (LayerNorm). מבנה זה מזרז התכנסות ומסייע בזרימת גרדיאנטים ברשת עמוקה.[16]

מורכבות חישובית - עלות הקשב‑העצמי המלא (O(n²·d)) מוגבלת בפועל על‑ידי מקביליות GPU, אך בהקשרים ארוכים במיוחד (n ≫ 1,000) פותחו וריאציות Sparse/Mobile כדי להקטין את המורכבות. למאמר המקורי ב‑2017 היה רצף הקלט קצר יחסית (עד 100 מילים), ולכן העלות הריבועית לא היוותה מגבלה מרכזית.

פרטי האימון המקוריים

הניסוי המקורי בוצע על מערכי הנתונים של תחרות WMT לשנת 2014, עבור זוגות השפות אנגלית-גרמנית (En→De) ואנגלית-צרפתית (En→Fr). לאחר סינון סטנדרטי, גודל הקורפוס עמד על כ‑4.5 מיליון משפטים (≈ 90 מיליון מילים) ל‑En–De וכ‑36 מיליון משפטים ל‑En–Fr.

תצורת המודל (Base)

dmodel = 512 ; dff = 2048 מספר ראשים: 8

שכבות: 6 מקודד + 6 מפענח

Dropout = 0.1 ; Label Smoothing = 0.1

סך הכול ≈ 65 מיליון פרמטרים

היפר־פרמטרים ואופטימיזציה

המודל אומן באופטימיזציית Adam (β₁ = 0.9, β₂ = 0.98, ε = 10⁻⁹) ובגודל Batch אפקטיבי של 25 אלף טוקנים. קצב הלמידה הותאם באמצעות פונקציית warm‑up מצולעת: lr = dmodel‑0.5 × min(step‑0.5, step × warmup‑1.5) עם 4,000 צעדי warm‑up.

האימון רץ על שמונה כרטיסי Nvidia P100 למשך ≈ 12 שעות ל‑En→De קיצור של יותר מ‑90 אחוז לעומת GNMT מבוסס RNN (≈ 10 ימים).

| מערכת | זוג שפות | ניקוד BLEU | זמן אימון |

|---|---|---|---|

| Transformer (base) | En→De | 27.3 | כ־12 שעות |

| Transformer (big) | En→De | 28.4 | כ־3 ימים |

| GNMT (RNN) | En→De | 24.6 | כ־10 ימים |

במקרה En→Fr, גרסת "big" של ה‑Transformer (7 כרטיסי P100, dmodel = 1024, 16 ראשים) הגיעה ל‑41.8 BLEU—כ‑2 נק׳ שיפור על GNMT.[17]

קוד פתוח

קוד המקור ופייפליין האימון פורסמו כחלק מפרויקט Tensor2Tensor תחת רישיון Apache 2.0, ותרמו לשחזור מהיר של התוצאות בקהילה.

השפעה ואימוץ

אימוץ מחקרי ואקדמי

מאז פרסומו ב‑2017 נחשב ה‑Transformer לאחת הארכיטקטורות המצוטטות ביותר במדעי המחשב. קצב הציטוטים השנתי טיפס מ‑≈600 בשנת 2017 ל‑≈45,000 בשנת 2024, והמאמר חצה 173 אלף ציטוטים ביוני 2025.

מודלים נגזרים בולטים

| שנה | מודל נגזר | תחום/יישום עיקרי | מקור |

|---|---|---|---|

| 2018 | BERT | Pre-training ל-NLP | Devlin et al. |

| 2018 | GPT-1 | מודלי שפה מחוללים | Radford et al. |

| 2020 | ViT | ראייה ממוחשבת | Dosovitskiy et al. |

| 2020 | T5 | המרה כללית של טקסט לטקסט | Raffel et al. |

| 2021 | AlphaFold 2 | חיזוי מבנה חלבונים | Jumper et al. |

אימוץ תעשייתי

מאז 2018 עבר Google Translate ממנוע RNN למנוע טרנספורמר, וכך השירות נעשה מהיר יותר הן בהפעלה והן בזמן ההמתנה.[18]

ChatGPT ו‑Gemini - מודלי שפה שפותחו על עקרונות קשב‑עצמי סקלבילי, עם מאות מיליארדי פרמטרים.

GitHub Copilot - כלי השלמת קוד בזמן אמת הנשען על Codex (הרחבת GPT‑3) ומאיץ את פרודוקטיביות המפתחים.[19]

Stable Diffusion, Midjourney - מודלים מחוללי תמונה היוצרים יצירה אמנותית בהנחיית טקסט; משלבים בלוקים של ויז'ן‑טרנספורמר בדיפיוזיה.

AlphaFold 2 – אומץ על‑ידי תעשיית התרופות והביוטק לאבחון חלבונים ולגילוי תרופות.

מדדים כלכליים

חברת McKinsey העריכה בשנת 2024 כי טרנספורמרים בליבה של בינה מלאכותית יוצרת עשויים להוסיף 2-4 טריליון דולר לשווי הכלכלה הגלובלית בשנה.

ביקורת ואתגרים

במקביל להצלחתו רחבת־ההיקף של הטרנספורמר, עלו בשיח האקדמי והתעשייתי מספר סוגיות ביקורתיות

דרישות חישוב וצריכת אנרגיה

הרחבת הארכיטקטורה למודלי‑ענק (כמו GPT‑3, PaLM, Gemini) חייבה אלפי GPU או TPU ומתקני‑ענן עתירי אנרגיה. חוקרים העריכו כי אימון מודל NLP גדול בודד עלול לפלוט > 284 טון CO₂—פי חמישה ממחזור חיים של מכונית.[20] חברות שביקשו לצמצם טביעת‑רגל פיתחו וריאציות Sparse Transformer ו‑Low‑Rank Adaptation (LoRA) כדי להפחית עלויות.

הטיות אלגוריתמיות והזיות תוכן

כמו מודלי שפה אחרים, טרנספורמרים גדולים לומדים מאגרי טקסט הטומנים בחובם עמדות ומיקרו‑הטיות. חוקרים הזהירו מפני "תוכניות‑תוכי" (Stochastic Parrots) שעלולות לשעתק דעות קדומות ולייצר מידע כוזב בביטחון גבוה.[21] כדי להתמודד, גובשה פרקטיקת Alignment Training, הכוללת RLAIF וסינון Datasets.

סוגיות אתיות ורגולציה

חקיקת AI Act באיחוד האירופי (2024) וסמכויות NIST בארצות הברית מטילות על מפתחי מודלים חובה לספק שקיפות לגבי מאגרי‑אימון, צריכת אנרגיה ומדדי‑ביצוע. גוגל, OpenAI ואחרות אימצו דוחות Model Card מפורטים.[22]

שיקולי קניין רוחני

יצירת טקסט או תמונה על ידי טרנספורמר עשויה להסתמך על נתוני אימון מוגנים בזכויות יוצרים. פסיקות בבתי משפט בארצות הברית ובריטניה (בשנים 2023–2025) ניסו להתוות גבולות בין שימוש הוגן לבין הפרה טכנולוגית של יצירות.

למרות האתגרים, קהילה רחבה ממשיכה לעבוד על מודלים יעילים ובטוחים יותר, לדוגמה Transformer Sparse, Performer (2020) ו‑Mamba (2023), במטרה לשמור על ביצועים תוך הפחתת עלויות ומשאבים.

קישורים חיצוניים

אתר האינטרנט הרשמי של Attention Is All You Need

אתר האינטרנט הרשמי של Attention Is All You Need- איך טרנספורמר עובד והקשר המפתיע שלו להופעה בתשובות של ChatGPT

- הטרנספורמרים משנים את עולם הבינה המלאכותית

הערות שוליים

- ↑ Vaswani, Ashish; Shazeer, Noam; Parmar, Niki; Uszkoreit, Jakob; Jones, Llion; Gomez, Aidan N.; Kaiser, Łukasz; Polosukhin, Illia (2017). Attention Is All You Need. NIPS 30.

- ↑ Goldman, Sharon (2024-03-20). "'Attention is All You Need' creators look beyond Transformers for AI at Nvidia GTC: 'The world needs something better'". VentureBeat. נבדק ב-2024-04-01.

- ↑ Shinde, Gitanjali; Wasatkar, Namrata; Mahalle, Parikshit (2024-06-06). Data-Centric Artificial Intelligence for Multidisciplinary Applications. CRC Press. p. 75. ISBN 9781040031131.

- ↑ "The rise of the transformer". Nature Machine Intelligence. 5: 1–2. 2023. doi:10.1038/s42256-022-00614-0.

- ↑ https://scholar.google.com/scholar?hl=en&as_sdt=0%2C5&q=Attention_Is_All_You_Need&btnG=

- ↑ https://www.nature.com/articles/d41586-025-01125-9

- ↑ Simonite, Tom (2022-09-15). "Eight Google Researchers Invented Modern AI—Then Left". Wired.

- ↑ Bengio, Yoshua (1994). "Learning long-term dependencies with gradient descent is difficult". IEEE Transactions on Neural Networks. 5 (2): 157–166.

- ↑ Bahdanau, Dzmitry; Cho, Kyunghyun; Bengio, Yoshua (2015). Neural Machine Translation by Jointly Learning to Align and Translate. ICLR 2015.

- ↑ Gehring, Jonas (2017). Convolutional Sequence to Sequence Learning. ICML 2017.

- ↑ "Transformer: A Novel Neural Network Architecture for Language Understanding". Google AI Blog. Google. 2017-08-31. נבדק ב-2025-06-09.

- ↑ "NIPS 2017 Accepted Papers Statistics". NIPS. נבדק ב-2025-06-09.

- ↑ "Tensor2Tensor for Neural Machine Translation". GitHub. נבדק ב-2025-06-09.

- ↑ Murgia, Madhumita (2023-07-23). "Transformers: the Google scientists who pioneered an AI revolution". Financial Times. נבדק ב-2025-03-22.

- ↑ Alammar, Jay (2018-06-27). "The Illustrated Transformer". נבדק ב-2025-06-09.

- ↑ Ba, Jimmy Lei; Kiros, Jamie; Hinton, Geoffrey (2016). Layer Normalization. arXiv preprint.

- ↑ Popel, M. (2018). "Training Tips for the Transformer Model". The Prague Bulletin of Mathematical Linguistics. 110: 43–70.

- ↑ "Google AI Blog – Advancing the state of Machine Translation". 2018-11-15.

- ↑ "Introducing GitHub Copilot". 2021-06-29.

- ↑ Emma Strubell, Ananya Ganesh, Andrew McCallum, Energy and Policy Considerations for Deep Learning in NLP, Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics, Association for Computational Linguistics, 2019-07, עמ' 3645–3650 doi: 10.18653/v1/P19-1355

- ↑ Emily M. Bender, Timnit Gebru, Angelina McMillan-Major, Shmargaret Shmitchell, On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜, Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency, FAccT '21, Association for Computing Machinery, 2021-03-01, עמ' 610–623 doi: 10.1145/3442188.3445922

- ↑ "EU AI Act: Political agreement reached". 2024-12-07.

|}

Attention Is All You Need41679857Q30249683